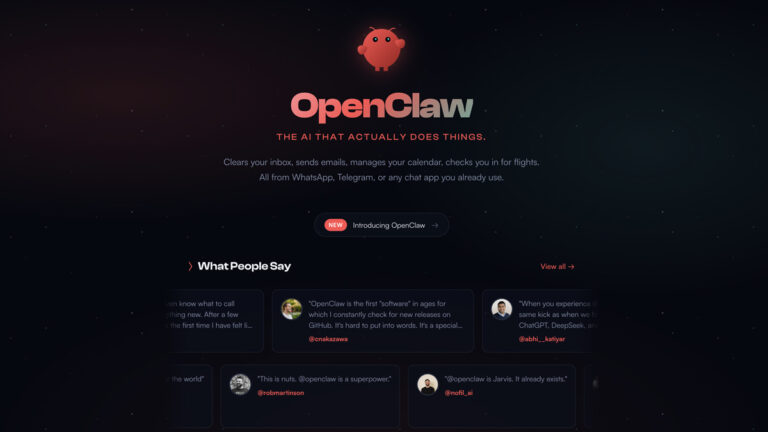

Moltbot, anciennement connu sous le nom de Clawdbot, fait figure de nouvelle étoile montante dans le monde de l’intelligence artificielle. Il s’agit d’un assistant IA open source autonome qui tourne en continu sur une machine locale et « transforme des conversations en actions concrètes ». Né de l’esprit du développeur autrichien Peter Steinberger, Moltbot a rapidement suscité un engouement viral en se présentant comme une « IA qui fait réellement des choses », par opposition aux simples chatbots génératifs traditionnels. En quelques semaines, ce projet a fédéré des milliers de développeurs : il a accumulé des dizaines de milliers d’étoiles sur GitHub et des centaines de contributeurs, témoignant d’une croissance fulgurante au sein de la communauté open source. Face à cet enthousiasme des développeurs, la communauté cybersécurité tire toutefois la sonnette d’alarme : Moltbot inquiète les experts quant à la sécurité des données et au contrôle de cet agent ultra-puissant. Pour des décideurs IT (CIO, CTO, RSSI, etc.), il est crucial de comprendre ce qu’est Moltbot, ses fonctionnalités, son architecture, son positionnement vis-à-vis d’autres IA, ses cas d’usage avancés en entreprise, mais aussi les risques techniques et de cybersécurité qu’il porte, ainsi que les implications en matière de gouvernance IT et de modèles de confiance.

Qu’est-ce que Moltbot ? Un assistant IA autonome qui passe à l’action

Moltbot se distingue des chatbots classiques par son autonomie d’exécution. Là où ChatGPT, Claude ou d’autres IA génératives bien connus restent confinés dans des interfaces de conversation et ne font que répondre à des requêtes, Moltbot agit. Il s’installe directement sur votre propre machine ou un serveur privé, et vous interagissez avec lui via une application de chat familière (WhatsApp, Telegram, iMessage, Discord, etc.). En arrière-plan, Moltbot fonctionne comme un « orchestrateur » open source qui sert de passerelle entre vos applications de messagerie, vos outils numériques et un modèle d’IA de votre choix. Concrètement, lorsque vous lui envoyez un message (par exemple “réserve mon prochain vol” ou “organise mes réunions de la semaine”), Moltbot détermine les étapes à effectuer, appelle un modèle IA approprié (parmi ceux d’OpenAI, d’Anthropic comme Claude, de Google, voire un modèle local via Ollama) pour raisonner ou générer du code si besoin, puis exécute des actions réelles sur la machine hôte ou via des API externes. Cette architecture locale-first, où l’agent tourne chez l’utilisateur et non dans le cloud, permet à Moltbot de s’intégrer profondément dans la vie numérique de l’utilisateur – sans nécessiter d’ouvrir un site web ni de copier-coller des prompts.

Open source et auto-hébergé, Moltbot offre l’avantage que les données restent a priori sous le contrôle de l’utilisateur, au lieu d’être systématiquement transmises à des services cloud tiers. C’est l’une des raisons de son succès : pour de nombreux passionnés, Moltbot apparaît comme une réponse à la méfiance vis-à-vis des IA 100 % cloud. Son créateur explique avoir voulu une solution où l’on peut bénéficier d’un assistant puissant tout en restant maître de ses données. D’ailleurs, Moltbot utilise les API de modèles externes (OpenAI, Anthropic, Google…) sans imposer de fournisseur unique : l’utilisateur peut choisir le moteur d’IA qu’il préfère juger le plus fiable, une liberté rare loin des écosystèmes fermés des grands acteurs. En pratique, Moltbot combine plus de 50 intégrations, compétences et plugins développés par la communauté, une mémoire longue (persistante) pour retenir le contexte à travers les sessions, et des capacités de contrôle étendu du système (navigateur web, accès fichiers, etc.). On le décrit volontiers comme “l’IA personnelle telle qu’on la voit dans les films” : un agent capable d’interagir avec tous vos services numériques et d’agir à votre place dans le monde digital, au-delà de la simple conversation.

Positionnement dans l’écosystème : un agent proactif face aux chatbots passifs

Le positionnement de Moltbot parmi les agents IA modernes se comprend en le comparant aux solutions existantes comme ChatGPT (OpenAI), Claude (Anthropic) ou les assistants vocaux type Siri/Alexa. ChatGPT et consorts sont des IA très puissantes en génération de langage, mais ce sont essentiellement des services cloud, réactifs, limités à répondre à des questions ou produire du texte. Ils ne prennent pas d’initiative par eux-mêmes et ne s’intègrent pas nativement à vos applications quotidiennes. Moltbot, à l’inverse, s’apparente à un assistant personnel autonome fonctionnant en continu, beaucoup plus proactif. Comme le résume un observateur, « Moltbot fait paraître les assistants IA normaux, comme Siri et Alexa, bien limités et désuets », car il peut accomplir un éventail quasi illimité de tâches impliquant différentes applications, du code et le web, là où les assistants classiques restent cloisonnés.

En quelque sorte, Moltbot est à l’IA ce qu’un employé numérique polyvalent serait à un simple conseiller virtuel. Il anticipe certains besoins au lieu d’attendre systématiquement une commande explicite. Par exemple, l’assistant peut de lui-même vérifier des conditions ou échéances (agenda, délais, événements clés) et vous envoyer un message proactif quand quelque chose requiert votre attention. Beaucoup d’utilisateurs décrivent l’expérience non plus comme discuter avec un bot, mais comme collaborer avec « un collègue numérique qui anticipe et exécute » des tâches à vos côtés. Cette proactivité et cette intégration dans le flux de travail quotidien tranchent radicalement avec le mode d’interaction ponctuel de ChatGPT ou Claude.

En outre, Moltbot ne se limite pas à un seul modèle d’IA ni à un seul domaine. Il peut tour à tour mobiliser les capacités de GPT-4 (OpenAI) pour une tâche de rédaction, puis d’un modèle Claude pour résumer un document, ou encore d’un modèle local pour des données sensibles, selon ce que l’utilisateur préfère. Cette flexibilité le place comme un méta-assistant orchestrant plusieurs IA en arrière-plan. À bien des égards, Moltbot concrétise la vision d’assistant universel que beaucoup attendaient : « une IA qui ne se contente pas de répondre, mais qui opère » réellement dans notre environnement numérique.

Ce concept d’“agent IA” est en vogue : des projets comme AutoGPT, BabyAGI ou les agents conversationnels augmentés des grands fournisseurs poursuivent des objectifs similaires d’automatisation. Moltbot se démarque en étant open source, communautaire et auto-hébergé, là où les alternatives des géants restent propriétaires ou limitées. Il offre un avant-goût de ce que pourrait être l’assistant personnel du futur – Google a d’ailleurs lancé timidement une initiative appelée “Personal Intelligence” dans cette direction – mais Moltbot pousse l’idée beaucoup plus loin et sans les verrous qui brident généralement les assistants officiels. Cette absence de limites et de contrôles intégrés fait à la fois son attrait et son problème, comme nous le verrons.

Fonctionnalités et cas d’usages avancés en entreprise

Les capacités de Moltbot couvrent un large spectre de tâches d’automatisation, ce qui ouvre des cas d’usage avancés, y compris en entreprise. Voici quelques exemples concrets de ce que Moltbot sait faire :

- Gestion des communications et agendas : Moltbot peut prendre en charge votre boîte e-mail, trier les messages, y répondre ou les résumer, mais aussi gérer votre agenda en programmant des réunions et en résolvant les conflits de planning. Il est capable d’envoyer des notifications matinales avec votre emploi du temps du jour et vos priorités. Certains utilisateurs l’emploient pour rappeler automatiquement les dates d’examens ou de devoirs de leurs enfants, démontrant sa capacité à gérer des calendriers partagés complexes.

- Automatisation de tâches administratives et métiers : Là où un collaborateur humain perdrait du temps, Moltbot peut remplir des formulaires en ligne, extraire et compiler des informations de divers outils (par exemple agréger des notes depuis Notion ou des tickets depuis Jira/Trello), ou encore générer des rapports périodiques. Dans le monde du développement, des early adopters l’ont détourné pour automatiser des routines comme la création de tickets GitHub ou même lancer des déploiements en continu. L’agent peut par exemple surveiller l’arrivée de nouvelles demandes et initier des workflows de traitement sans intervention humaine.

- Interactions sur le web et systèmes externes : Moltbot peut piloter un navigateur web pour effectuer des actions à votre place : acheter un billet d’avion dès sa mise en vente, réserver une table de restaurant, récupérer des données sur un site, etc.. Couplé à des services tiers, il sait aussi contrôler des objets connectés (domotique) ou des applications de collaboration (poster des messages sur Slack/Teams, interagir sur les réseaux sociaux). En entreprise, on pourrait imaginer un Moltbot configuré pour surveiller des indicateurs clés en ligne (réseaux sociaux, retours clients) et signaler toute anomalie ou opportunité.

- Exécution de scripts et opérations IT : Grâce à ses permissions locales, Moltbot peut exécuter des commandes shell ou des scripts sur la machine hôte. Ceci permet d’automatiser des opérations IT répétitives ou nocturnes. Par exemple, un administrateur pourrait lui déléguer la rotation de logs, le redémarrage de services ou le déploiement d’un patch sur plusieurs serveurs (via SSH), en ne recevant une alerte de Moltbot qu’en cas d’erreur. Des développeurs ont expérimenté l’intégration de Moltbot dans des pipelines DevOps pour qu’il travaille en continu à lancer des tests, surveiller des builds et déployer du code. Ce type d’usage, encore expérimental, montre comment un agent IA peut agir comme un stagiaire numérique exécutant des tâches techniques de premier niveau.

Ces exemples ne sont qu’un aperçu : Moltbot est en réalité un cadre extensible. La communauté peut développer de nouvelles skills (compétences) ou plugins et les ajouter au ClawdHub/Molthub, un registre de compétences partagées. On a ainsi vu fleurir des extensions allant de la génération de synthèses vocales quotidiennes à la gestion automatique de factures. Un utilisateur enthousiaste confie même vouloir déployer Moltbot pour gérer la petite entreprise familiale de distribution de thé : il forme son père à s’en servir pour traiter les factures fournisseurs, suivre les stocks et communiquer avec les clients, convaincu que « ce système généraliste peut faire tourner un business ». En milieu professionnel, Moltbot pourrait agir en véritable assistant polyvalent, déchargeant les équipes de nombreuses tâches chronophages (saisie de données, planification, support de niveau 1, etc.) et améliorant la réactivité (notifications instantanées, exécution 24/7).

Il convient toutefois de noter que malgré son potentiel, Moltbot n’est pas encore un produit “clé en main” pour le grand public ni pour les entreprises. Son déploiement requiert une certaine expertise technique (ligne de commande, configuration de proxy, récupération de clés API…) et ses intégrations doivent être réglées finement pour correspondre aux cas d’usage métier. Pour une DSI, envisager Moltbot implique donc une phase d’expérimentation dans un cadre contrôlé, avec des cas d’emploi ciblés où les bénéfices d’automatisation surpassent les coûts de mise en place.

Un phénomène viral porté par la communauté open source

L’ascension de Moltbot a été fulgurante, alimentée par les réseaux sociaux et la communauté open source. Lancé initialement sous le nom “Clawdbot” en novembre 2025, le projet a été rebaptisé Moltbot fin janvier 2026 suite à une requête de la société Anthropic (celle-ci estimait que le nom “Clawd” ressemblait trop à son IA “Claude”). Ce changement de nom précipité a provoqué une petite tempête sur GitHub (multiplication des forks et confusion autour des liens), ce qui n’a fait qu’ajouter à la publicité involontaire du projet.

En l’espace de quelques jours début 2026, Moltbot est devenu un véritable buzz sur X (Twitter) et les forums tech. Des figures influentes de la tech se sont publiquement enthousiasmées de leurs expérimentations. Dave Morin, entrepreneur bien connu, a déclaré : « C’est la première fois depuis le lancement de ChatGPT que j’ai l’impression de vivre dans le futur » en parlant de Moltbot. D’autres ont comparé le frisson ressenti à celui des débuts de ChatGPT ou du premier code généré par une IA, témoignant que quelque chose de fondamental semble changer dans notre interaction avec l’IA. Sur les réseaux, un refrain est revenu chez les adeptes : « le futur est déjà là », porté par ce nouvel assistant capable de véritables actions.

La viralité s’est manifestée par quelques anecdotes éloquentes. L’idée d’acheter un Mac Mini dédié pour faire tourner Moltbot 24h/24 est rapidement devenue un mème en ligne, au point que des photos de Mac Minis empilés “en grappe” ont fleuri sur X. Beaucoup de développeurs bricoleurs se sont rués sur ces petits ordinateurs, ravis de monter chez eux un serveur domestique bon marché pour leur agent IA – une sorte de revival du home lab. Moltbot a réveillé chez certains le plaisir d’expérimenter et d’innover en marge des solutions packagées des géants du cloud. Cette dynamique communautaire – faite de partages de configurations, de tutorials sur YouTube, d’échanges sur Discord – a amplement contribué à son essor. Le projet a dépassé les 40 000 étoiles GitHub en quelques jours fin janvier 2026, figurant parmi les croissances les plus rapides sur la plateforme open source.

Toutefois, ce succès a un revers : la frénésie autour de Moltbot n’est pas passée inaperçue des acteurs malveillants. Des escrocs ont profité du changement de nom pour lancer de faux dépôts GitHub imitant Moltbot ou même un faux token “Clawdbot AI” qui a réussi à soutirer 16 millions de dollars aux investisseurs crédules avant de s’effondrer. Ce type d’abus opportuniste montre que la popularité soudaine d’un projet open source peut aussi créer un terreau fertile pour les arnaques, et souligne l’importance pour les curieux de n’utiliser que le dépôt officiel et les sources de confiance.

Risques techniques et cybersécurité : un pouvoir sans précédent, des dangers réels

Si Moltbot fascine par tout ce qu’il promet de faire, il inquiète tout autant par les risques qu’il fait peser sur la sécurité. Plusieurs experts en cybersécurité ont publiquement mis en garde contre une adoption irréfléchie de cet agent IA extrêmement permissif. Comme le résume un article, du point de vue de la sécurité Moltbot est « un véritable cauchemar » pour qui ne mesure pas les implications de lui confier ses tâches informatiques. Voici les principaux risques techniques et cyber identifiés dans la presse récente, qu’un DSI/RSSI doit avoir à l’esprit :

- Privilèges étendus sur le système et les comptes : Pour fonctionner, Moltbot nécessite des autorisations très larges : accès aux comptes de messagerie, aux API de vos services, capacité d’exécuter des commandes shell, de lire/écrire des fichiers, de lancer des scripts, etc.. En pratique, utiliser Moltbot équivaut à remettre les clés de votre identité numérique à un agent automatisé. Mal configuré ou compromis, celui-ci pourrait alors causer des dégâts considérables. Cisco, dans un billet de blog, qualifie Moltbot de « cauchemar absolu » en soulignant qu’accorder des privilèges élevés à une IA revient à inviter les ennuis si un attaquant parvient à le détourner. Les chercheurs Cisco notent d’ailleurs des cas où Moltbot a divulgué en clair des clés API et identifiants, récupérables par un tiers malveillant via une simple injection de commande ou un accès non sécurisé. En d’autres termes, plus l’agent a de pouvoirs, plus la portée d’une éventuelle compromission est grande.

- Instances exposées et fuites de données : L’engouement a mené nombre de développeurs à déployer Moltbot rapidement, parfois sans bien sécuriser l’installation. Des chercheurs white hat ont découvert des centaines d’instances Moltbot en ligne sans aucune protection par mot de passe ou authentification. Conséquence : certaines de ces instances ouvertes ont laissé fuiter des informations sensibles telles que des clés API Anthropic, des jetons de bots Telegram, des secrets de signature ou des historiques de conversations entières. Jamieson O’Reilly, chercheur en sécurité et fondateur de Dvuln, a tiré la sonnette d’alarme après avoir repéré ces instances mal configurées connectées au web en libre accès. Les développeurs du projet ont réagi en urgence en publiant des correctifs de sécurité et de nouvelles recommandations de configuration pour atténuer le problème. Mais le message est clair : si Moltbot n’est pas rigoureusement cloisonné, il peut devenir une porte grande ouverte sur vos données. Toute entreprise tentée de l’expérimenter devrait impérativement le faire sur une machine isolée et avec une configuration robuste (authentification forte, absence d’exposition directe à internet, etc.).

- Vulnérabilité aux attaques par prompt injection : Les prompt injections représentent une menace émergente propre aux IA conversationnelles – et Moltbot en hérite de plein fouet. Il s’agit d’insérer dans un contenu (page web, email, document) des instructions malveillantes à l’attention de l’IA, de sorte qu’en le lisant celle-ci exécute des actions non prévues par l’utilisateur. Moltbot, qui lit et analyse des sources externes pour accomplir ses tâches, pourrait ainsi être amené à lire un message piégé. Par exemple, un simple texte caché dans un email ou une page web pourrait ordonner à l’agent d’envoyer des données à un serveur pirate ou de réaliser une action dangereuse sur votre système. « Voyez les choses ainsi : les hackers du monde entier se réjouissent en se préparant à détruire votre vie », avertit ainsi Rahul Sood (CEO d’Irreverent Labs) à propos du modèle de sécurité de Moltbot/Clawdbot, qu’il juge très inquiétant. Même si vous seul envoyez des messages à votre bot, l’injection de commande peut survenir via tout contenu non fiable que le bot consulte (résultats web, documents, pièces jointes…). La documentation de Moltbot reconnaît d’ailleurs que « il n’existe pas de configuration parfaitement sécurisée » et qu’aucune solution définitive n’a encore été trouvée contre les attaques par prompt injection dans les agents IA modernes. Autrement dit, tant que l’IA restera susceptible d’être influencée par ses entrées, il faudra considérer ce vecteur comme un risque majeur.

- Compétences et extensions malveillantes : L’écosystème ouvert de Moltbot permet à chacun de développer des skills. Hélas, comme dans tout dépôt public (pensons aux packages npm, pip, etc.), des acteurs malintentionnés peuvent proposer des plugins piégés. Fin janvier, des analystes ont signalé l’apparition d’une fausse extension VS Code nommée “ClawdBot Agent” qui, sous prétexte d’intégration, était en réalité un cheval de Troie visant à installer un logiciel d’accès à distance sur les machines cibles. De même, O’Reilly (mentionné plus haut) a mené une expérience édifiante : il a publié une compétence apparemment sûre mais dotée d’une backdoor cachée, et l’a rendue très visible sur le hub de compétences. En quelques heures, des milliers d’utilisateurs l’avaient téléchargée, lui donnant potentiellement un accès total à leurs systèmes. S’il n’en a pas abusé et a révélé la supercherie à titre pédagogique, l’expérience prouve que l’installation irréfléchie de modules tiers peut compromettre gravement l’agent et, par ricochet, votre environnement. Malheureusement, ce scénario reproduit les failles historiques de la supply chain open source, avec des conséquences potentiellement plus graves encore ici (puisque l’agent a de larges permissions). Il est donc indispensable de valider soigneusement toute extension avant de l’ajouter à Moltbot, et de privilégier les plugins officiels ou vérifiés.

- Comportements imprévisibles et erreurs : Enfin, un danger plus diffus mais bien réel est lié à la part d’imprévisibilité des modèles de langage. Moltbot repose sur des IA qui peuvent parfois “halluciner” des informations ou mal interpréter une situation. Or, contrairement à un chatbot classique dont les divagations restent du texte, les hallucinations de Moltbot peuvent se traduire en actions réelles. Des utilisateurs ont rapporté des cas où l’agent envoyait des messages incohérents à des contacts, ou effectuait des actions non sollicitées, potentiellement nuisibles. « Imaginez une machine à halluciner qui peut couper le chauffage, faire des virements ou écrire à vos parents… on entrevoit vite les dérapages possibles », illustre L’Usine Digitale en relatant ces comportements erratiques observés. Ce risque d’erreur d’exécution signifie qu’il faut garder un œil critique sur les initiatives de l’agent, en particulier lors des premières utilisations, et peut-être éviter de l’autoriser sur des actions irréversibles tant qu’il n’est pas mûr (par exemple, on pourra lui laisser rédiger un email mais demander validation humaine avant envoi).

En somme, tout ce qui rend Moltbot puissant le rend également dangereux sans précautions. Les créateurs eux-mêmes reconnaissent que faire tourner un agent avec des droits étendus est “épicé” (pour reprendre leur euphémisme) et que la sécurité dépend en grande partie de l’utilisateur, de ses réglages et de sa vigilance. Moltbot peut rester local et privé, mais sans aucune garantie de sécurité intégrée : ce n’est pas un produit prêt pour l’entreprise avec SLA, support et conformité, mais un outil puissant encore expérimental qui demande expertise et prudence.

Gouvernance IT : quels contrôles et quel modèle de confiance face à l’agent Moltbot ?

L’émergence de Moltbot soulève des questions importantes pour la gouvernance IT et les modèles de confiance en entreprise. D’un côté, il incarne une avancée prometteuse vers des assistants numériques ultra-performants capables de soulager les collaborateurs. De l’autre, il bouscule nos cadres de gestion des accès, de la sécurité et de la confiance numérique. Les DSI et RSSI doivent donc anticiper comment encadrer l’usage de tels agents autonomes.

1. Contrôle des permissions et cloisonnement : Moltbot illustre la nécessité d’appliquer le principe de moindre privilège aux IA. Si une entreprise envisage de le tester, il est impératif de limiter strictement les permissions accordées à l’agent et de le cantonner dans un bac à sable (sandbox). Par exemple, on évitera de le déployer sur un poste contenant des données sensibles ou avec un accès réseau étendu. L’idéal est de le faire tourner sur une machine dédiée, isolée des systèmes critiques, avec des identifiants spécifiques créés pour l’occasion (comptes de test, boîtes mail secondaires, copies de données) afin de compartimenter les impacts éventuels. Éviter d’exposer l’instance directement à internet et forcer une authentification forte pour y accéder sont des mesures de base désormais évidentes. La gouvernance devra édicter des règles claires sur les environnements autorisés pour ce type d’agent (par ex. en labo innovation uniquement, sur des datasets anonymisés, etc.).

2. Évaluation et validation des compétences : Comme pour toute brique open source introduite dans le SI, un processus de validation de sécurité des plugins Moltbot s’impose. Les DSI pourraient s’inspirer des pratiques DevSecOps : scanner le code des skills tiers avant installation, n’autoriser que des sources approuvées, maintenir une liste blanche d’extensions autorisées et bannir celles signalées comme malveillantes. Cisco a d’ailleurs commencé à développer un outil open source de scan des compétences Claude/OpenClaw pour détecter d’éventuels comportements dangereux dans le code ou les métadonnées des skills. Une telle démarche de vérification proactive pourrait être intégrée aux politiques de sécurité interne. Plus largement, l’entreprise doit se doter d’un modèle de confiance adapté aux IA autonomes : cela signifie établir des critères sur ce qui est confié ou non à l’agent, quels types de données et d’actions sont considérés comme acceptables, et comment auditer ses activités.

3. Sensibilisation des utilisateurs et prévention du Shadow IT : L’attrait viral de Moltbot peut pousser des employés technophiles à l’adopter de leur propre chef, potentiellement en dehors de tout cadre maîtrisé (c’est l’équivalent du Shadow IT, version IA). Il est crucial de sensibiliser les équipes aux risques spécifiques de ce genre d’outils. Une campagne de communication interne sur les promesses et dangers de Moltbot (et des agents IA en général) permettra d’éviter une utilisation imprudente sur le réseau de l’entreprise. Les décideurs IT doivent également envisager d’adapter les chartes informatiques : par exemple, interdire explicitement l’installation d’agents IA non validés sur les postes de travail professionnels, ou au minimum requérir une approbation de la DSI. L’objectif n’est pas de brider l’innovation, mais de s’assurer que si un cas d’usage légitime émerge pour Moltbot, il soit mené en concertation avec l’IT et dans le respect des règles de sécurité.

4. Vers de nouveaux modèles de confiance “IA” : Moltbot cristallise enfin une interrogation centrale : jusqu’où sommes-nous prêts à déléguer notre vie numérique (personnelle ou professionnelle) à une machine ? Pour les dirigeants, cela pose la question de la confiance. Faut-il faire confiance à un agent open source communautaire pour gérer nos données et nos processus ? Peut-on lui accorder la même confiance qu’à un service cloud réputé, ou doit-on au contraire s’en méfier davantage du fait de son caractère non encadré ? Il est probable que de nouveaux labels de confiance ou certifications émergeront pour les agents IA, à l’image des normes de sécurité logicielle, afin de rassurer les entreprises sur un minimum de garanties (ex. conformité RGPD, audit du code, contrôle des accès). En attendant, la confiance devra être progressive et conditionnelle : un agent comme Moltbot pourrait d’abord se voir confier des tâches non sensibles en test, gagner la confiance par ses résultats et son comportement sûr, avant d’espérer accéder à des responsabilités plus critiques. Les DSI auront un rôle de gardiens pour définir ces paliers de confiance et surveiller en continu que l’agent reste dans les clous.

Conclusion : innovation à embrasser prudemment

Moltbot marque une étape importante dans l’évolution des assistants pilotés par l’IA. Pour la première fois, un agent grand public – ouvert et modifiable par tous – démontre qu’il est possible de déléguer des tâches entières à une IA fonctionnant de façon autonome, avec une efficacité souvent bluffante. Ce faisant, il offre aux DSI un aperçu concret de la façon dont l’IA pourrait s’intégrer dans le flux du travail quotidien, en étant non plus une simple application isolée mais un véritable coéquipier numérique qui se souvient, anticipe et agit. Les cas d’usage potentiels en entreprise ne manqueront pas, de l’automatisation des opérations IT à l’assistance administrative en passant par la coordination de projets.

Cependant, comme nous l’avons détaillé, cette puissance s’accompagne de risques techniques et sécuritaires majeurs. Moltbot, en l’état actuel (début 2026), est un outil expérimental qui n’offre pas les garanties requises pour un usage en production dans une entreprise sans mesures drastiques. Son arrivée soudaine est un rappel brutal des défis de sécurité qui accompagnent l’IA agentique de nouvelle génération. Permissions excessives, fiabilité du comportement, protection des données, maîtrise de la supply chain logicielle : autant de chantiers que la généralisation de ces agents va imposer aux services IT. La question n’est plus théorique : Moltbot montre que la technologie existe déjà et qu’elle séduit des utilisateurs prêts à tout lui déléguer, « sans tenir compte des problèmes de confidentialité » observe Wired.

Pour la gouvernance IT, le mot d’ordre doit être équilibre. Il serait dommage d’ignorer les opportunités offertes par ces assistants IA autonomes – en termes de productivité, d’innovation et même d’avantage compétitif – mais il serait tout aussi irresponsable de les adopter sans contrôle. Une approche recommandée est de traiter Moltbot (et ses semblables) comme on le ferait d’une nouvelle embauche non testée : on commence par des tâches simples, on surveille étroitement, on pose des garde-fous, on évalue les résultats et on élargit progressivement le champ d’action en fonction de la confiance gagnée. En parallèle, il faut rester informé des évolutions du projet : la communauté open source travaille déjà à des playbooks pour simplifier une configuration plus sûre, et on peut s’attendre à ce que des forks orientés “entreprise” ou des versions modifiées apparaissent pour renforcer la sécurité et la conformité.

En définitive, Moltbot incarne autant un immense potentiel qu’un puissant avertissement. Cet agent “homard numérique” qui peut prendre le contrôle de nos vies digitales montre ce qui est désormais possible – pour le meilleur et pour le pire. Aux CIO, CTO et RSSI d’en tirer les leçons pour préparer dès aujourd’hui leurs organisations à l’essor de ces agents IA autonomes, en embrassant prudemment l’innovation tout en redoublant de vigilance sur la confiance et la sécurité. Comme souvent avec les technologies disruptives, ceux qui sauront trouver le juste milieu entre enthousiasme et rigueur en tireront le plus grand bénéfice, tandis que les imprudents pourraient en payer le prix fort. Moltbot nous invite donc à avancer, mais les yeux grands ouverts.